Microsoft сегодня заявила, что выпустила «наиболее функциональные и экономически эффективные модели малого языка (SLM) из доступных», заявив, что Phi-3 — третья итерация семейства Phi моделей малого языка (SLM) — превосходит модели сопоставимого размера и несколько более крупных.

Модель малого языка (SLM) — это тип модели искусственного интеллекта, который предназначен для чрезвычайно эффективного выполнения конкретных задач, связанных с языком. В отличие от моделей большого языка (LLM), которые хорошо подходят для широкого спектра общих задач, SLM построены на меньшем наборе данных, что делает их более эффективными и экономичными для конкретных случаев использования.

По словам Microsoft, Phi-3 выпускается в разных версиях, самой маленькой из которых является Phi-3 Mini, модель с 3,8 миллиардами параметров, обученная на 3,3 триллионах токенов. Несмотря на свой сравнительно небольшой размер — корпус Llama-3 весит более 15 триллионов токенов данных — Phi-3 Mini по-прежнему способен обрабатывать 128 тысяч токенов контекста. Это делает его сопоставимым с GPT-4 и превосходит Llama-3 и Mistral Large по емкости токенов.

Другими словами, такие гиганты ИИ, как Llama-3 на Meta.ai и Mistral Large, могут рухнуть после долгого разговора или подсказки задолго до того, как эта легкая модель начнет испытывать трудности.

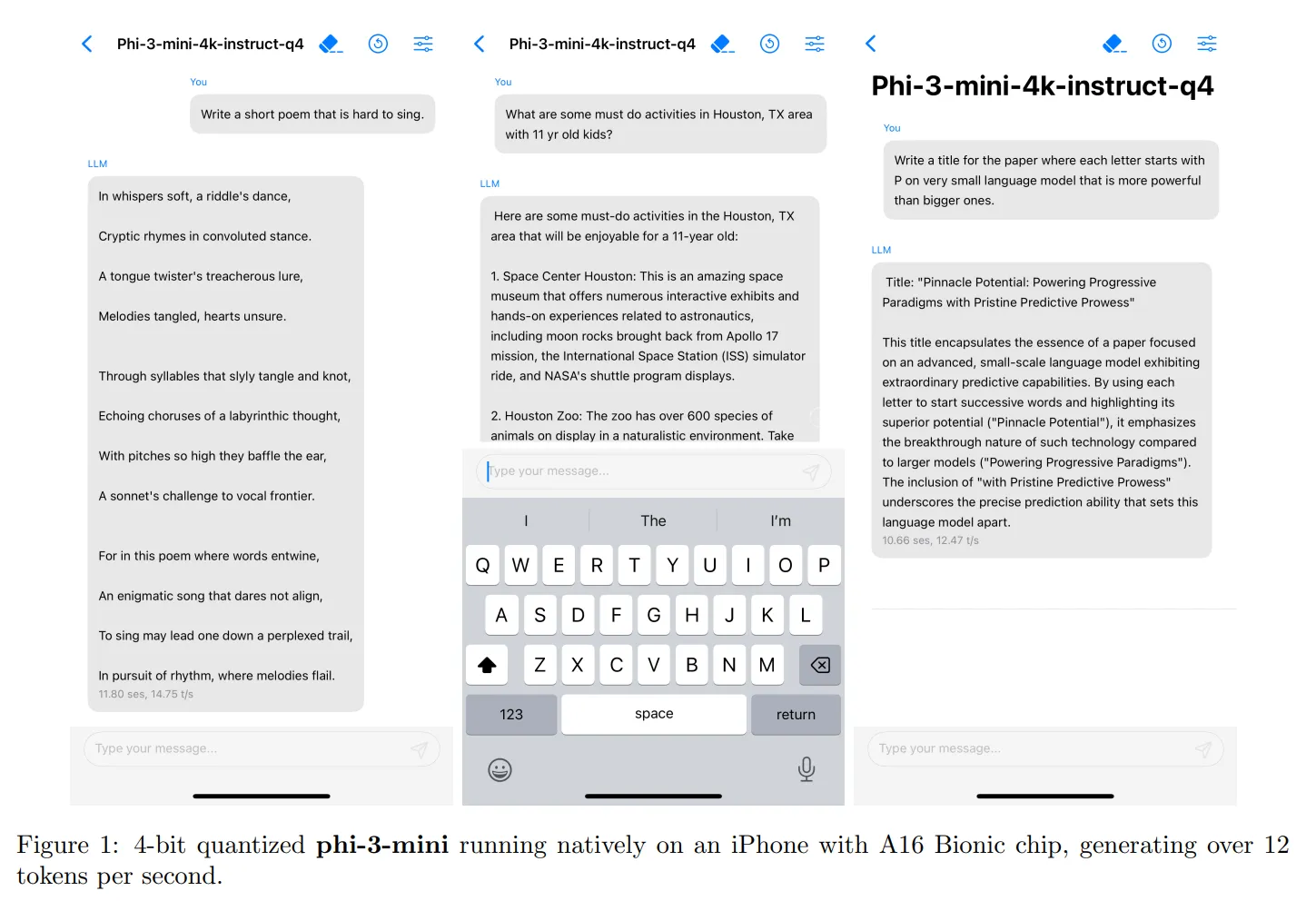

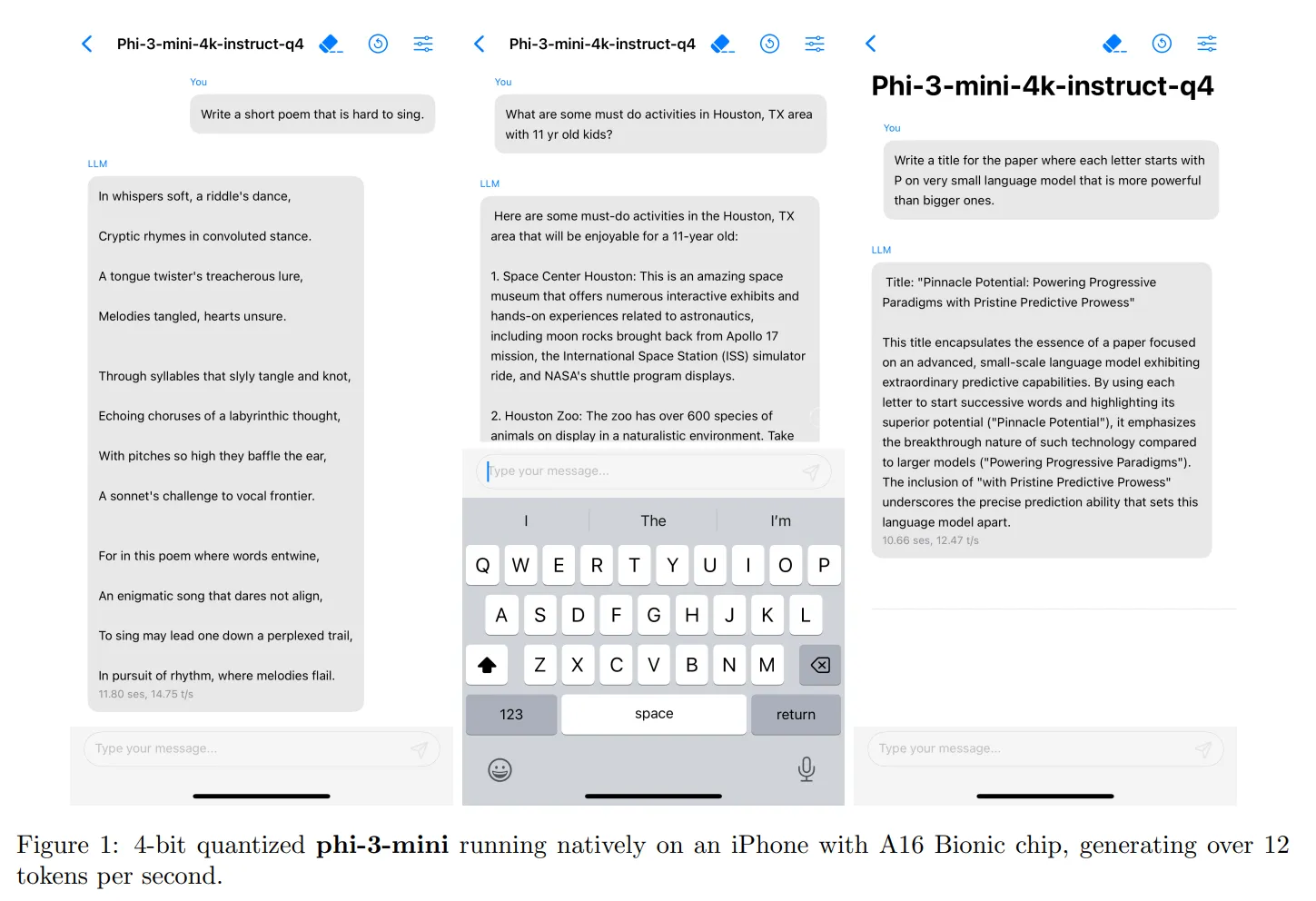

Одним из наиболее значительных преимуществ Phi-3 Mini является его способность работать на обычном смартфоне. Microsoft протестировала модель на iPhone 14, и она работала без проблем, генерируя 14 токенов в секунду. Для работы Phi-3 Mini требуется всего 1,8 ГБ видеопамяти, что делает его легкой и эффективной альтернативой для пользователей с более конкретными требованиями.

Хотя Phi-3 Mini может не подойти высококлассным программистам или людям с широкими требованиями, он может стать эффективной альтернативой для пользователей с особыми потребностями. Например, стартапы, которым нужен чат-бот, или люди, использующие LLM для анализа данных, могут использовать Phi-3 Mini для таких задач, как организация данных, извлечение информации, математические рассуждения и создание агентов. Если модели предоставить доступ к Интернету, она может стать довольно мощной, компенсируя недостаток возможностей информацией в реальном времени.

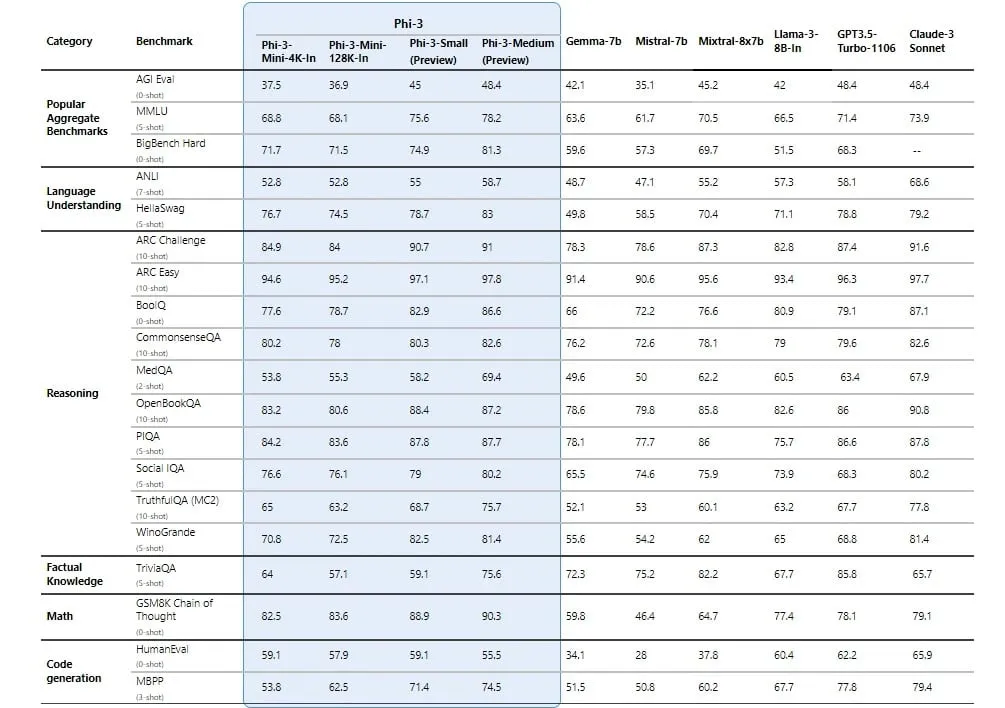

Phi-3 Mini достигает высоких результатов в тестах благодаря тому, что Microsoft стремится обеспечить свой набор данных максимально полезной информацией. На самом деле более широкое семейство Phi не подходит для задач, требующих фактических знаний, но высокие навыки рассуждения ставят их выше основных конкурентов. Phi-3 Medium (модель с 14 миллиардами параметров) постоянно превосходит мощные LLM, такие как GPT-3.5 — LLM, лежащий в основе бесплатной версии ChatGPT, — а версия Mini превосходит мощные модели, такие как Mixtral-8x7B, в большинстве синтетических тестов.

Однако стоит отметить, что Phi-3 не имеет открытого исходного кода, как его предшественник Phi-2. Вместо этого это открытая модель, то есть она доступна и доступна для использования, но не имеет такого же лицензирования с открытым исходным кодом, как Phi-2, что позволяет более широкое использование и коммерческое применение.

В ближайшие недели Microsoft заявила, что выпустит больше моделей семейства Phi-3, включая Phi-3 Small (7 миллиардов параметров) и вышеупомянутую Phi-3 Medium.

Microsoft сделала Phi-3 Mini доступным в Azure AI Studio, Hugging Face и Ollama. Модель настроена и оптимизирована для среды выполнения ONNX с поддержкой Windows DirectML, а также кроссплатформенной поддержкой различных графических процессоров, процессоров и даже мобильного оборудования.