Технологический институт Вирджинии (США) опубликовал отчет, в котором излагаются потенциальные предубеждения в инструменте искусственного интеллекта (ИИ) ChatGPT, предполагая различия в его результатах по вопросам экологической справедливости в разных округах.

В недавнем отчете исследователи из Технологического института Вирджинии заявили, что ChatGPT имеет ограничения в предоставлении конкретной информации по вопросам экологической справедливости.

Однако исследование выявило тенденцию, указывающую на то, что информация стала более доступной для более крупных и густонаселенных штатов.

«В штатах с большим городским населением, таких как Делавэр или Калифорния, менее 1 процента населения проживало в округах, которые не могут получить конкретную информацию».

Между тем, регионы с меньшим населением не имели аналогичного доступа.

«В сельских штатах, таких как Айдахо и Нью-Гэмпшир, более 90 процентов населения проживало в округах, которые не могли получать информацию, специфичную для местного населения», — говорится в отчете.

Далее он процитировал лектора по имени Ким с географического факультета Технологического института Вирджинии, который призвал к необходимости дальнейших исследований, поскольку обнаруживаются предрассудки.

«Хотя необходимы дополнительные исследования, наши результаты показывают, что в настоящее время в модели ChatGPT существуют географические предубеждения», — заявил Ким.

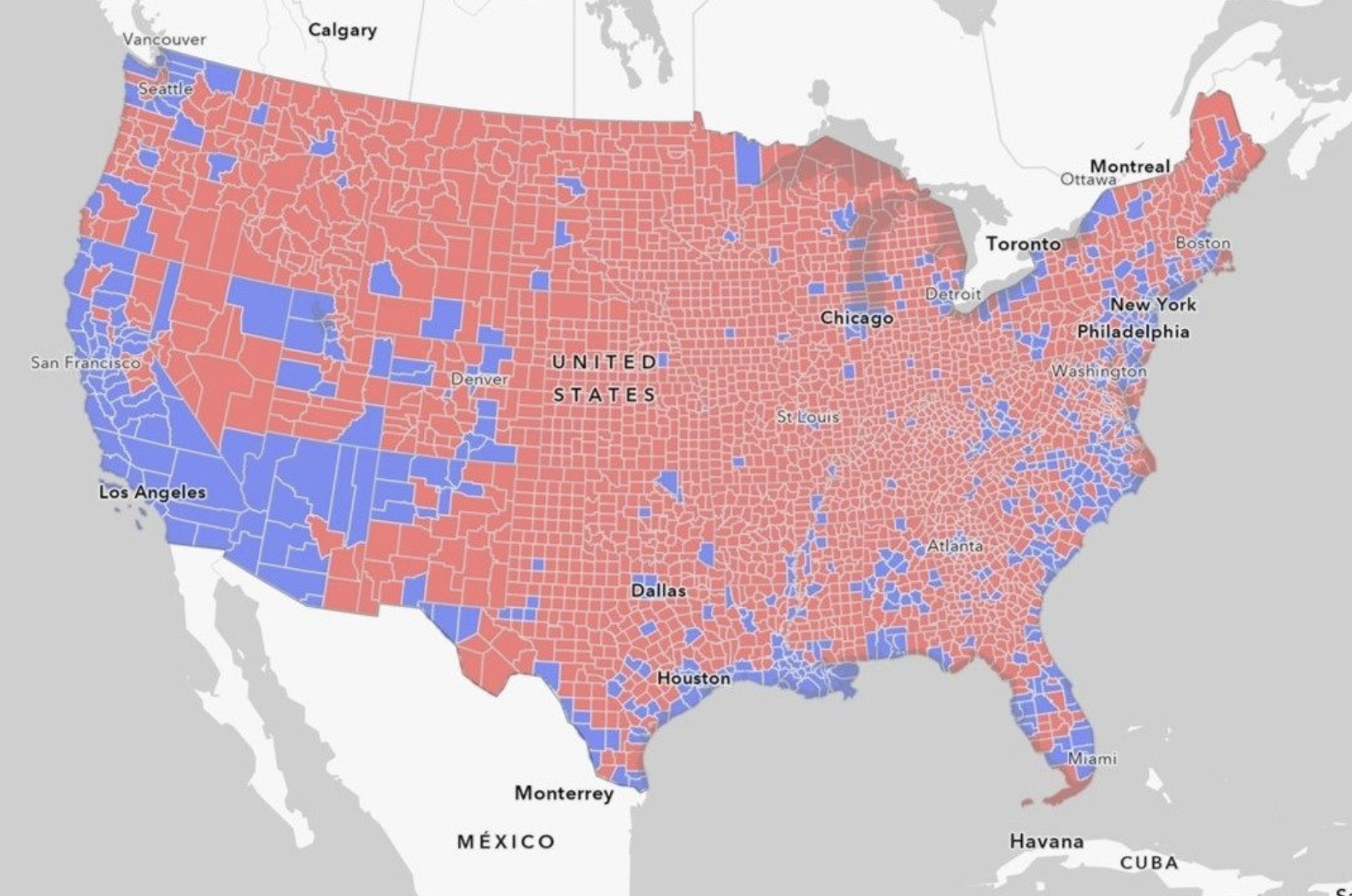

В исследовательский документ также включена карта, иллюстрирующая степень населения США, не имеющего доступа к конкретной информации по вопросам экологической справедливости.

Карта США, показывающая территории, где жители могут просматривать (синий) или не могут просматривать (красный) местную информацию по вопросам экологической справедливости. Источник: Технологический институт Вирджинии.

Карта США, показывающая территории, где жители могут просматривать (синий) или не могут просматривать (красный) местную информацию по вопросам экологической справедливости. Источник: Технологический институт Вирджинии.

Связанный: ChatGPT впервые сдал экзамен по неврологии

Это следует из недавних новостей о том, что ученые обнаруживают потенциальную политическую предвзятость, проявленную ChatGPT в последнее время.

25 августа сообщил, что исследователи из Великобритании и Бразилии опубликовали исследование, в котором заявили, что большие языковые модели (LLM), такие как выходной текст ChatGPT, содержат ошибки и предвзятости, которые могут ввести читателей в заблуждение и имеют возможность продвигать политические предубеждения, представленные традиционными СМИ. .

Журнал: Deepfake K-Pop порно, разбудил Грока, «У OpenAI проблема», Fetch.AI: AI Eye